Consultez le texte intégral de la loi sur l'IA en ligne à l'aide de notreexplorateur de la loi sur l'IA ( ).

Vérification de la conformité à la loi européenne sur l'IA

La loi européenne sur l'IA introduit de nouvelles obligations pour les entités situées dans l'UE et ailleurs. Utilisez notre outil interactif pour déterminer si votre système d'IA sera soumis à ces obligations.

Si vous souhaitez vous tenir au courant de vos obligations au titre de la loi européenne sur l'IA, nous vous recommandons de vous abonner à la lettre d'information sur la loi européenne sur l'IA.

Pour plus de clarté, nous vous recommandons de demander l'avis d'un professionnel du droit et de suivre les directives nationales. De plus amples informations sur l'application de la loi européenne sur l'IA dans votre pays seront probablement fournies en 2024.

Commentaires - Nous travaillons à l'amélioration de cet outil. Veuillez envoyer vos commentaires à Taylor Jones à l'adresse suivante : taylor@futureoflife.org

Le texte utilisé dans cet outil est la "Loi sur l'intelligence artificielle (Règlement (UE) 2024/1689), version du Journal officiel du 13 juin 2024". Dossier interinstitutionnel : 2021/0106(COD)

Changelog

26 mars 2024

- Correction d'un bug qui empêchait les déployeurs de recevoir leurs obligations au titre de l'article 29.

- Suppression de l'avis suivant dans le résultat "Obligations à haut risque" : "Une exclusion supplémentaire pour les systèmes qui sont "purement accessoires par rapport à l'action ou à la décision pertinente à prendre" sera définie au plus tard un an après l'introduction de la loi sur l'IA. Cette exclusion ne figure plus à l'article 7 du projet final.

11 mars 2024

- Mise à jour du vérificateur de conformité pour refléter la "version finale" de la loi sur l'IA.

Confidentialité des données : Afin de pouvoir vous envoyer vos résultats par courrier électronique, nous sommes tenus de conserver les données que vous avez saisies dans ce formulaire, y compris votre adresse électronique. Si vous n'utilisez pas la fonction d'envoi par courrier électronique, aucune de vos données ne sera stockée. Nous ne stockons aucune autre donnée susceptible d'être utilisée pour vous identifier ou identifier votre appareil. Si vous souhaitez rester anonyme, veuillez utiliser une adresse électronique qui ne révèle pas votre identité. Nous ne partageons aucune de vos données avec d'autres parties. Si vous souhaitez que vos données soient supprimées de nos serveurs, veuillez contacter taylor@futureoflife.org.

Questions fréquemment posées

Qui a développé cet outil et pourquoi ?

Cet outil a été développé par l'équipe du Future of Life Institute. Nous ne sommes en aucun cas affiliés à l'Union européenne. Nous avons développé cet outil volontairement afin de contribuer à la mise en œuvre efficace de la loi sur l'IA, car nous pensons que la loi sur l'IA soutient notre mission visant à garantir que la technologie de l'IA reste bénéfique pour la vie et qu'elle évite les risques extrêmes à grande échelle.

Puis-je intégrer cet outil dans mon propre site web ?

Notre outil est conçu de manière à ce qu’il soit difficile de prendre en charge la mise en œuvre sur d’autres sites. Nous n’avons pas d’API disponible. Par conséquent, dans presque tous les cas, nous vous suggérons de mettre cet outil à la disposition des utilisateurs de votre site Web en créant un lien vers cette page Web – vous êtes invités à utiliser ces images de maquette pour présenter l’outil sur votre site.

Quand la loi européenne sur l'IA entre-t-elle en vigueur ?

Quelles sont les catégories de risques définies par la loi européenne sur l'IA ?

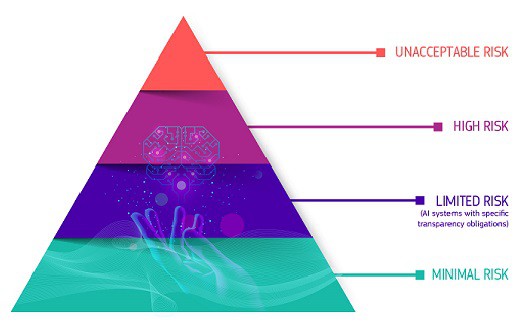

Le cadre réglementaire de la loi définit quatre niveaux de risque pour les systèmes d'IA : inacceptable, élevé, limité et minimal ou nul. Les systèmes présentant des risques inacceptables, tels que la menace pour la sécurité, les moyens de subsistance et les droits des personnes - de la notation sociale par les gouvernements aux jouets utilisant l'assistance vocale - seront interdits. Les systèmes à haut risque, tels que ceux utilisés dans les infrastructures critiques ou par les forces de l'ordre, seront soumis à des exigences strictes, notamment en matière d'évaluation des risques, de qualité des données, de documentation, de transparence, de surveillance humaine et d'exactitude. Les systèmes présentant des risques limités, comme les robots de conversation, doivent respecter des obligations de transparence afin que les utilisateurs sachent qu'ils n'interagissent pas avec des humains. Les systèmes à risque minimal, tels que les jeux et les filtres anti-spam, peuvent être utilisés librement.

Quelle est la part des systèmes d'IA qui entreront dans la catégorie des systèmes à haut risque ?

Il est difficile de savoir quelle proportion de systèmes d'IA entrera dans la catégorie à haut risque, car le domaine de l'IA et la législation sont encore en pleine évolution. La Commission européenne a estimé dans une étude d'impact que seulement 5 à 15 % des applications seraient soumises à des règles plus strictes. Une étude d'appliedAI portant sur 106 systèmes d'IA d'entreprise a révélé que 18 % d'entre eux présentaient un risque élevé, 42 % un risque faible et 40 % ne savaient pas s'il s'agissait d'un risque élevé ou faible. Les systèmes dont la classification des risques n'était pas claire dans cette étude relevaient principalement des domaines des infrastructures critiques, de l'emploi, de l'application de la loi et de la sécurité des produits. Dans une enquête connexe menée auprès de 113 startups européennes spécialisées dans l'IA, 33 % des startups interrogées pensaient que leurs systèmes d'IA seraient classés comme présentant un risque élevé, contre 5 à 15 % selon l'évaluation de la Commission européenne.

Quelles sont les sanctions prévues par la loi européenne sur l'IA ?

Selon la position adoptée par le Parlement européen, le recours aux pratiques interdites en matière d'intelligence artificielle visées à l'article 5 peut entraîner des amendes allant jusqu'à 40 millions d'euros ou 7 % du chiffre d'affaires annuel mondial, le montant le plus élevé étant retenu. Le non-respect des exigences en matière de gouvernance des données (article 10) et des exigences en matière de transparence et de fourniture d'informations (article 13) peut entraîner des amendes allant jusqu'à 20 millions d'euros ou 4 % du chiffre d'affaires mondial, le montant le plus élevé étant retenu. Le non-respect de toute autre exigence ou obligation peut entraîner des amendes allant jusqu'à 10 millions d'euros ou 2 % du chiffre d'affaires mondial - là encore, le montant le plus élevé est retenu. Les amendes sont échelonnées en fonction de la disposition enfreinte, les pratiques interdites étant sanctionnées par les amendes les plus élevées et les autres violations par des amendes maximales moins élevées.

Quelles mesures la loi européenne sur l'IA met-elle en œuvre pour les PME en particulier ?

La loi européenne sur l'IA vise à soutenir les PME et les startups, comme le précise l'article 55. Les mesures spécifiques comprennent l'octroi d'un accès prioritaire aux bacs à sable réglementaires pour les PME et les startups basées dans l'UE si les critères d'éligibilité sont remplis. En outre, des activités de sensibilisation et de développement des compétences numériques seront organisées pour répondre aux besoins des petites organisations. En outre, des canaux de communication dédiés seront mis en place pour offrir des conseils et répondre aux questions des PME et des startups. La participation des PME et des autres parties prenantes au processus d'élaboration des normes sera également encouragée. Afin de réduire la charge financière liée à la conformité, les frais d'évaluation de la conformité seront réduits pour les PME et les startups en fonction de facteurs tels que le stade de développement, la taille et la demande du marché. La Commission examinera régulièrement les coûts de certification et de mise en conformité pour les PME et les jeunes entreprises (en s'appuyant sur des consultations transparentes) et collaborera avec les États membres pour réduire ces coûts dans la mesure du possible.

Puis-je me conformer volontairement à la loi européenne sur l'IA même si mon système n'entre pas dans son champ d'application ?

Oui ! La Commission, l'AI Office et/ou les États membres encourageront les codes de conduite volontaires pour les exigences du titre III, chapitre 2 (par exemple, la gestion des risques, la gouvernance des données et la surveillance humaine) pour les systèmes d'IA qui ne sont pas considérés comme présentant un risque élevé. Ces codes de conduite fourniront des solutions techniques sur la manière dont un système d'IA peut satisfaire aux exigences, en fonction de l'objectif visé par le système. D'autres objectifs tels que la durabilité environnementale, l'accessibilité, la participation des parties prenantes et la diversité des équipes de développement seront pris en compte. Les petites entreprises et les jeunes pousses seront prises en compte lors de l'élaboration des codes de conduite. Voir l'article 69 sur les codes de conduite pour l'application volontaire d'exigences spécifiques.