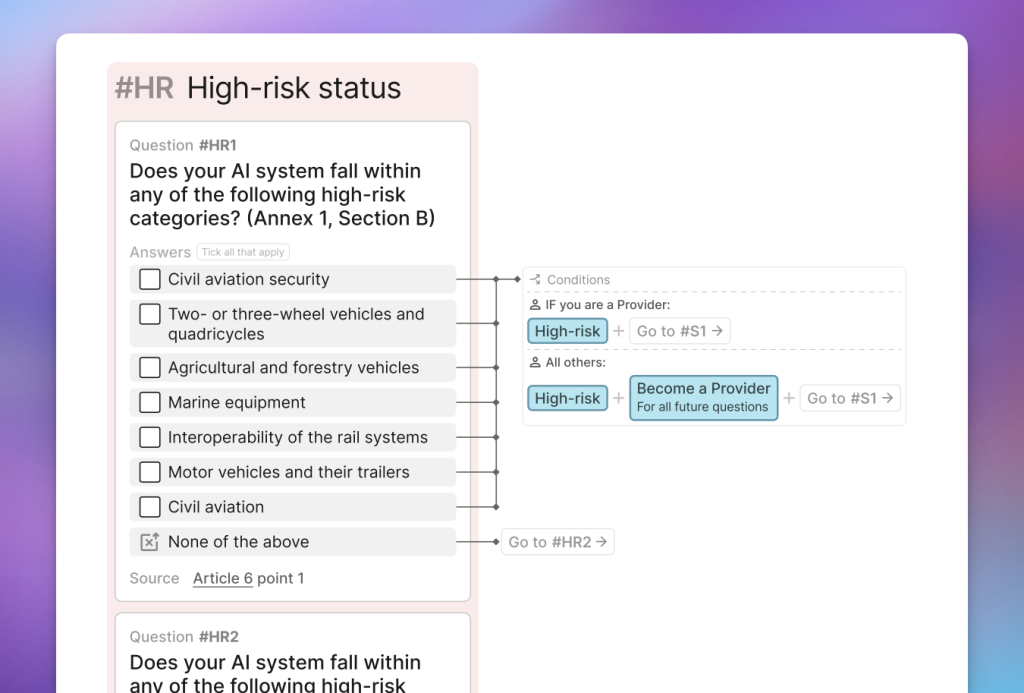

Sfogliare il testo completo della legge sull'AI online utilizzando il nostro AI Act Explorer.

Controllo della conformità alla legge sull'AI dell'UE

L'EU AI Act introduce nuovi obblighi per le entità situate all'interno dell'UE e altrove. Utilizzate il nostro strumento interattivo per determinare se il vostro sistema di IA sarà soggetto o meno a questi obblighi.

Se desiderate essere aggiornati sui vostri obblighi ai sensi dell'EU AI Act, vi consigliamo di iscrivervi alla EU AI Act Newsletter.

Per maggiore chiarezza, si consiglia di rivolgersi a un legale professionista e di seguire le indicazioni nazionali. Maggiori informazioni sull'applicazione della legge europea sull'AI nel vostro Paese saranno probabilmente fornite nel 2024.

Visualizzare il programma di verifica della conformità come diagramma di flusso in formato PDF NUOVO

Visualizzate una panoramica visiva dell'intera logica del modulo e salvatela per l'accesso offline.

Feedback - Stiamo lavorando per migliorare questo strumento. Inviate il vostro feedback a Taylor Jones all'indirizzo taylor@futureoflife.org

Visualizzate il testo ufficiale o sfogliatelo online utilizzando il nostro AI Act Explorer. Il testo utilizzato in questo strumento è la "Legge sull'intelligenza artificiale (Regolamento (UE) 2024/1689), versione della Gazzetta ufficiale del 13 giugno 2024". Fascicolo interistituzionale: 2021/0106(COD)

Changelog

3 luglio 2025

- Gli obblighi del Distributore e dell'Importatore vengono ora mostrati solo se il sistema AI dell'utente è ad alto rischio.

- Fornisce una descrizione completa degli obblighi per i fornitori di sistemi di IA ad alto rischio.

- Aggiornata la descrizione degli obblighi dei Distributori per riflettere più accuratamente il testo legale.

25 aprile 2025

- Aggiunta di una domanda e di obblighi per i "Fornitori di modelli di IA per scopi generali con rischio sistemico".

16 aprile 2025

- In precedenza, i Rappresentanti autorizzati erano trattati come Fornitori. Ora hanno una logica di forma distinta e ricevono solo gli obblighi del Rappresentante Autorizzato.

- I produttori di prodotti ricevono ora domande relative all'ambito prima di valutare se il loro sistema è ad alto rischio.

- Aggiunti obblighi specifici per i fabbricanti di prodotti.

- Aggiunta una nota per informare gli utenti che possono essere considerati "operatori" ai sensi dell'articolo 3, e che quindi hanno obblighi corrispondenti.

- Chiarito il linguaggio relativo agli obblighi di trasparenza.

- Chiarito il linguaggio relativo all'ambito di applicazione per gli importatori.

- Rimossa un'opzione di ambito ridondante.

- La domanda "Modelli di intelligenza artificiale per scopi generali" è stata fusa con la domanda "Ambito" per semplificare il modulo per i fornitori.

15 aprile 2025

- Sono stati aggiunti obblighi di "alfabetizzazione all'intelligenza artificiale" per i fornitori e gli implementatori.

- Aggiunta la domanda "Valutazione dell'impatto sui diritti fondamentali" e gli obblighi per chi impiega sistemi di IA ad alto rischio.

- Modificato il linguaggio relativo ai "modelli di IA per scopi generali" per garantire che non vi sia confusione tra "modelli" e "sistemi".

- Chiarito il linguaggio sui sistemi di intelligenza artificiale vietati, in particolare sui sistemi di riconoscimento delle emozioni.

- Chiarito il linguaggio delle esenzioni per le "attività personali e non professionali" e per le "autorità pubbliche o organizzazioni internazionali in paesi terzi".

1° aprile 2025

- È stata eseguita una significativa rifattorizzazione dell'ordinamento del modulo per evitare che si verifichino bug in alcuni casi limite. In particolare, sono state spostate le domande "ad alto rischio" molto prima nel modulo, in modo da poter determinare molto prima se determinate entità "diventano un fornitore" ai sensi degli articoli 22 e 25.

26 marzo 2024

- Corretto un bug che impediva ai Deployer di ricevere gli obblighi previsti dall'Articolo 29.

- Rimosso il seguente avviso nel risultato "Obblighi ad alto rischio": "Un'ulteriore esclusione per i sistemi che sono "puramente accessori rispetto alla relativa azione o decisione da prendere" sarà definita entro un anno dall'introduzione della legge sull'AI." Questa esclusione non è più presente nell'articolo 7 della bozza finale.

11 marzo 2024

- Aggiornato il Compliance Checker per riflettere la "bozza finale" dell'AI Act.

Privacy dei dati: Per potervi inviare i risultati via e-mail, siamo tenuti a memorizzare i vostri dati inseriti in questo modulo, compreso il vostro indirizzo e-mail. Se non utilizzate la funzione e-mail, nessuno dei vostri dati verrà memorizzato. Non memorizziamo nessun altro dato che possa essere utilizzato per identificare l'utente o il suo dispositivo. Se desiderate rimanere anonimi, utilizzate un indirizzo e-mail che non riveli la vostra identità. Non condividiamo i vostri dati con altre parti. Se desiderate che i vostri dati vengano cancellati dai nostri server, contattate taylor@futureoflife.org.

Ringraziamenti:

La logica di questo modulo è stata testata da Tomas Bueno Momcilovic, ricercatore scientifico di Fortiss. La traduzione in giapponese è stata fornita da Citadel AI.

Domande frequenti

Chi ha sviluppato questo strumento e perché?

Questo strumento è stato sviluppato dal team del Future of Life Institute. Non siamo in alcun modo affiliati all'Unione Europea. Abbiamo sviluppato questo strumento volontariamente per favorire l'effettiva attuazione della legge sull'IA, perché riteniamo che la legge sull'IA sostenga la nostra missione di garantire che la tecnologia dell'IA rimanga benefica per la vita ed eviti rischi estremi su larga scala.

Posso integrare questo strumento nel mio sito web?

Il nostro strumento è costruito in modo tale da rendere difficile l'implementazione su altri siti. Non disponiamo di un'API. Pertanto, per la quasi totalità dei casi, vi suggeriamo di mettere questo strumento a disposizione degli utenti del vostro sito web tramite:

A) Collegamento a questa pagina web: siete invitati a utilizzare queste immagini mockup per presentare lo strumento sul vostro sito.

B) Incorporare la versione a pagina intera di questo strumento all'interno del vostro sito come iframe. Si noti che gli iframe possono essere difficili da usare sui dispositivi mobili e aggiungono nuovi cookie e script ai dispositivi degli utenti. Pertanto, questo metodo non è consigliato.

Quando entra in vigore la legge sull'IA dell'UE?

La legge europea sull'AI è entrata in vigore il 1° agosto 2024. Segue ora un periodo di attuazione di due o tre anni, poiché le varie parti della legge entrano in vigore in date diverse. Il nostro calendario di attuazione fornisce una panoramica di tutte le date chiave relative all'attuazione della legge.

Durante il periodo di attuazione, si prevede che gli organismi di normazione europei sviluppino standard per l'AI Act.

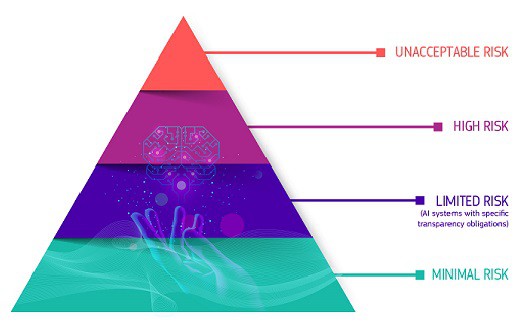

Quali sono le categorie di rischio definite dall'EU AI Act?

Il quadro normativo della legge definisce quattro livelli di rischio per i sistemi di intelligenza artificiale: inaccettabile, elevato, limitato e minimo o nullo. I sistemi che presentano rischi inaccettabili, come la minaccia alla sicurezza, ai mezzi di sussistenza e ai diritti delle persone - dal social scoring dei governi ai giocattoli che utilizzano l'assistenza vocale - saranno vietati. I sistemi ad alto rischio, come quelli utilizzati nelle infrastrutture critiche o nelle forze dell'ordine, dovranno soddisfare requisiti rigorosi, tra cui la valutazione del rischio, la qualità dei dati, la documentazione, la trasparenza, la supervisione umana e l'accuratezza. I sistemi che presentano rischi limitati, come i chatbot, devono rispettare gli obblighi di trasparenza in modo che gli utenti sappiano che non stanno interagendo con esseri umani. I sistemi a rischio minimo, come i giochi e i filtri antispam, possono essere utilizzati liberamente.

Quale percentuale di sistemi di IA rientrerà nella categoria ad alto rischio?

Non è certo quale percentuale di sistemi di IA rientrerà nella categoria ad alto rischio, poiché sia il campo dell'IA che la legge sono ancora in evoluzione. La Commissione europea ha stimato in uno studio d'impatto che solo il 5-15% delle applicazioni sarà soggetto a regole più severe. Uno studio condotto da appliedAI su 106 sistemi di IA aziendali ha rilevato che il 18% era ad alto rischio, il 42% a basso rischio e il 40% non era chiaro se ad alto o basso rischio. I sistemi con una classificazione del rischio non chiara in questo studio erano principalmente nei settori delle infrastrutture critiche, dell'occupazione, delle forze dell'ordine e della sicurezza dei prodotti. In un'indagine correlata su 113 startup dell'UE che si occupano di IA, il 33% delle startup intervistate riteneva che i propri sistemi di IA sarebbero stati classificati come ad alto rischio, rispetto al 5-15% valutato dalla Commissione europea.

Quali sono le sanzioni previste dalla legge sull'IA dell'UE?

In base alla posizione adottata dal Parlamento europeo, l'utilizzo di pratiche di IA vietate di cui all'articolo 5 può comportare multe fino a 40 milioni di euro o al 7% del fatturato mondiale annuo, se superiore. Il mancato rispetto dei requisiti di governance dei dati (ai sensi dell'articolo 10) e dei requisiti di trasparenza e fornitura di informazioni (ai sensi dell'articolo 13) può portare a multe fino a 20 milioni di euro, o al 4% del fatturato mondiale, se superiore. L'inosservanza di qualsiasi altro requisito o obbligo può comportare multe fino a 10 milioni di euro o al 2% del fatturato mondiale, sempre se superiore. Le ammende sono graduate a seconda della disposizione violata, con le pratiche vietate che ricevono le sanzioni più alte e le altre violazioni che ricevono ammende massime più basse.

Quali sono le misure che l'EU AI Act attua specificamente per le PMI?

La legge europea sull'intelligenza artificiale mira a fornire sostegno alle PMI e alle startup, come specificato nell'articolo 55. Tra le misure specifiche vi è la concessione di un accesso prioritario alle sandbox normative per le PMI e le startup con sede nell'UE, se vengono soddisfatti i criteri di ammissibilità. Inoltre, saranno organizzate attività di sensibilizzazione e di sviluppo delle competenze digitali su misura per rispondere alle esigenze delle organizzazioni più piccole. Inoltre, saranno creati canali di comunicazione dedicati per offrire orientamenti e rispondere alle domande di PMI e startup. Sarà inoltre incoraggiata la partecipazione delle PMI e di altre parti interessate al processo di sviluppo degli standard. Per ridurre l'onere finanziario della conformità, le tariffe per la valutazione della conformità saranno ridotte per le PMI e le start-up in base a fattori quali la fase di sviluppo, le dimensioni e la domanda di mercato. La Commissione riesaminerà regolarmente i costi di certificazione e conformità per le PMI/startup (con il contributo di consultazioni trasparenti) e collaborerà con gli Stati membri per ridurre tali costi, ove possibile.

Posso conformarmi volontariamente all'EU AI Act anche se il mio sistema non rientra nell'ambito di applicazione?

Sì! La Commissione, l'Ufficio AI e/o gli Stati membri incoraggeranno codici di condotta volontari per i requisiti di cui al Titolo III, Capitolo 2 (ad esempio, gestione del rischio, governance dei dati e supervisione umana) per i sistemi di IA non considerati ad alto rischio. Questi codici di condotta forniranno soluzioni tecniche per il modo in cui un sistema di IA può soddisfare i requisiti, in base alla finalità del sistema stesso. Verranno presi in considerazione altri obiettivi come la sostenibilità ambientale, l'accessibilità, la partecipazione degli stakeholder e la diversità dei team di sviluppo. Nell'incoraggiare i codici di condotta si terrà conto delle piccole imprese e delle startup. Si veda l'articolo 69 sui Codici di condotta per l'applicazione volontaria di requisiti specifici.

Fateci sapere di quali risorse avete bisogno

Stiamo cercando un feedback di 2 minuti sul sito web dell'AI Act, in modo da poter creare le risorse più utili per voi. Abbiamo prodotto molte delle risorse presenti sul nostro sito web in risposta diretta al feedback degli utenti, a volte in sole 1-2 settimane.

Questo sito nasce con l'obiettivo di fornire informazioni utili e oggettive sugli sviluppi relativi alla legge europea sull'intelligenza artificiale. È utilizzato da oltre 150.000 utenti ogni mese. Grazie in anticipo per il tempo e l'impegno che ci dedichi: speriamo di poterlo ricambiare con informazioni personalizzate e di alta qualità, in grado di soddisfare le tue esigenze.