Ознакомьтесь с полным текстом Закона об искусственном интеллекте в режиме онлайн, используя наш AI Act Explorer.

Программа проверки соответствия закону ЕС об искусственном интеллекте

Закон ЕС об искусственном интеллекте вводит новые обязательства для организаций, расположенных на территории ЕС и за его пределами. Воспользуйтесь нашим интерактивным инструментом, чтобы определить, будет ли ваша система искусственного интеллекта подпадать под их действие.

Если вы хотите быть в курсе ваших обязательств по Закону ЕС об искусственном интеллекте, рекомендуем подписаться на рассылку новостей о Законе ЕС об искусственном интеллекте.

Для большей ясности мы рекомендуем вам обратиться за профессиональной юридической консультацией и следовать национальным инструкциям. Более подробная информация о применении Закона ЕС об искусственном интеллекте в вашей стране, вероятно, будет предоставлена в 2024 году.

Просмотреть программу проверки соответствия в виде блок-схемы в формате PDF НОВИНКА

Просмотрите визуальный обзор всей логики формы и сохраните его для доступа в автономном режиме.

Обратная связь - Мы работаем над улучшением этого инструмента. Пожалуйста, присылайте отзывы Тейлору Джонсу по адресу taylor@futureoflife.org.

Ознакомьтесь с официальным текстом или просмотрите его в режиме онлайн с помощью нашего инструмента AI Act Explorer. В данном инструменте используется текст "Закона об искусственном интеллекте (Регламент (ЕС) 2024/1689), версия официального журнала от 13 июня 2024 года". Межинститутский файл: 2021/0106(COD)

Changelog

3 июля 2025 г.

- Обязательства дистрибьюторов и импортеров теперь отображаются только в том случае, если система искусственного интеллекта пользователя относится к категории высокого риска.

- Представлено полное описание обязательств для поставщиков систем искусственного интеллекта с высокой степенью риска.

- Обновлено описание обязательств для развертывателей, чтобы более точно отразить юридический текст.

25 апреля 2025 г.

- Добавлены вопросы и обязательства для "Поставщиков моделей ИИ общего назначения с системным риском".

16 апреля 2025 г.

- Ранее Уполномоченные представители рассматривались как Провайдеры. Теперь они имеют отдельную логику формы и получают только обязательства уполномоченного представителя.

- Теперь производители продуктов получают вопросы, связанные с областью применения, прежде чем оценить, относится ли их система к системам высокого риска.

- Добавлены специальные обязательства для производителей продукции.

- Добавлено примечание, информирующее пользователей о том, что они могут считаться "оператором" в соответствии со статьей 3 и, следовательно, имеют соответствующие обязательства.

- Уточнены формулировки, касающиеся обязательств по обеспечению прозрачности.

- Уточнены формулировки, касающиеся области применения для импортеров.

- Удалена лишняя опция прицела.

- Вопрос "Модели ИИ общего назначения" объединен с вопросом "Область применения", чтобы упростить форму для поставщиков.

15 апреля 2025 г.

- Добавлены обязательства "Грамотность в области ИИ" для провайдеров и развертывателей.

- Добавлен вопрос "Оценка воздействия на фундаментальные права" и обязательства для разработчиков систем ИИ с высоким уровнем риска.

- Изменена формулировка "модели ИИ общего назначения", чтобы исключить путаницу между "моделями" и "системами".

- Уточнены формулировки, касающиеся запрещенных систем искусственного интеллекта, в частности, систем распознавания эмоций.

- Уточнены формулировки, касающиеся исключений для "личной, непрофессиональной деятельности" и для "государственных органов или международных организаций в третьих странах".

1 апреля 2025 г.

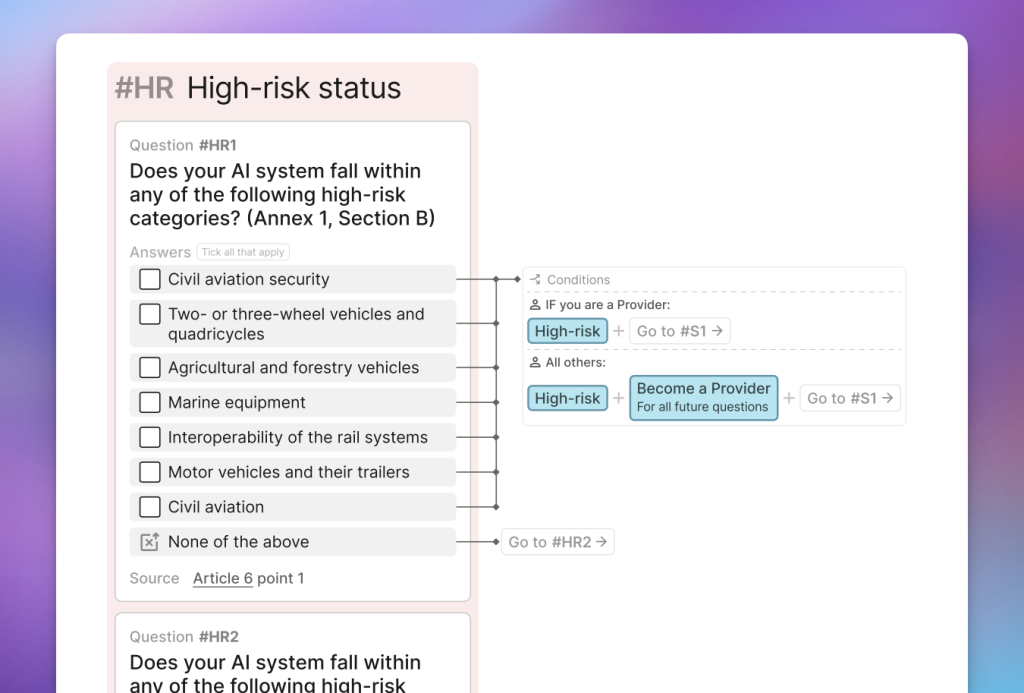

- Проведен значительный рефакторинг порядка заполнения формы, чтобы предотвратить ошибки, возникающие в некоторых крайних случаях. В частности, вопросы о "высоком риске" были перенесены в более раннюю часть формы, чтобы можно было гораздо раньше определить, становятся ли определенные организации "провайдерами" в соответствии со статьями 22 и 25.

26 марта 2024 г.

- Исправлена ошибка, из-за которой деплойеры не получали свои обязательства по статье 29.

- Удалено следующее уведомление в результатах "Обязательства с высоким риском": "Дополнительное исключение для систем, которые являются "чисто вспомогательными в отношении соответствующего действия или решения, которое должно быть принято", будет определено не позднее, чем через год после введения Закона об искусственном интеллекте". Это исключение больше не присутствует в статье 7 окончательного проекта.

11 марта 2024 г.

- Обновили программу проверки соответствия, чтобы отразить "окончательный проект" Закона об искусственном интеллекте.

Конфиденциальность данных: Чтобы отправить вам результаты по электронной почте, мы должны сохранить ваши данные, указанные в этой форме, включая адрес электронной почты. Если вы не используете функцию электронной почты, никакие ваши данные не будут сохранены. Мы не храним никаких других данных, которые могут быть использованы для идентификации вас или вашего устройства. Если вы хотите сохранить анонимность, пожалуйста, используйте адрес электронной почты, который не раскрывает вашу личность. Мы не передаем ваши данные никаким другим сторонам. Если вы хотите, чтобы ваши данные были удалены с наших серверов, пожалуйста, свяжитесь с нами по адресу taylor@futureoflife.org.

Благодарности:

Логика этой формы была протестирована Томашем Буэно Момчиловичем, научным сотрудником Fortiss. Перевод на японский язык предоставлен компанией Citadel AI.

Часто задаваемые вопросы

Кто и зачем разработал этот инструмент?

Этот инструмент разработан командой Института будущего жизни. Мы никоим образом не связаны с Европейским союзом. Мы разработали этот инструмент добровольно, чтобы помочь эффективному применению Закона об искусственном интеллекте, поскольку считаем, что Закон об искусственном интеллекте поддерживает нашу миссию по обеспечению того, чтобы технологии искусственного интеллекта оставались полезными для жизни и избегали чрезвычайно масштабных рисков.

Могу ли я интегрировать этот инструмент в свой собственный сайт?

Наш инструмент построен таким образом, что его сложно реализовать на других сайтах. У нас нет доступного API. Поэтому почти во всех случаях мы предлагаем вам сделать этот инструмент доступным для пользователей вашего сайта либо:

A) Ссылка на эту страницу - вы можете использовать эти изображения макета для демонстрации инструмента на своем сайте.

Б) Встраивание полностраничной версии этого инструмента на ваш сайт в виде iframe. Обратите внимание, что iframe могут быть неудобны для использования на мобильных устройствах, а также будут добавлять новые куки и скрипты на устройства ваших пользователей. Поэтому этот метод не рекомендуется.

Когда вступает в силу Закон ЕС об искусственном интеллекте?

Закон ЕС об искусственном интеллекте вступил в силу 1 августа 2024 года. Период его реализации займет от двух до трех лет, поскольку различные части Закона вступают в силу в разные даты. В нашем графике реализации представлен обзор всех ключевых дат, связанных с реализацией Закона.

Ожидается, что в течение периода внедрения европейские органы стандартизации разработают стандарты для Закона об искусственном интеллекте.

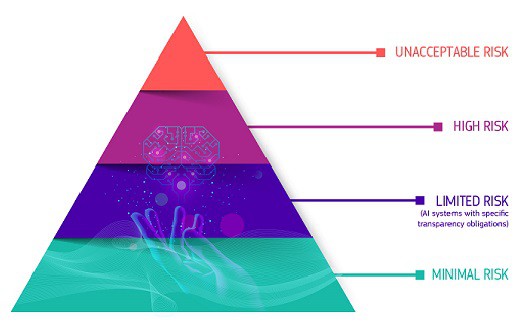

Какие категории риска определены в Законе ЕС об искусственном интеллекте?

Нормативная база закона определяет четыре уровня риска для систем ИИ: неприемлемый, высокий, ограниченный и минимальный или отсутствие риска. Системы, представляющие неприемлемый риск, например, угрожающие безопасности, средствам к существованию и правам людей - от социального скоринга правительств до игрушек, использующих голосовую помощь, - будут запрещены. К системам с высоким уровнем риска, например, используемым в критической инфраструктуре или правоохранительных органах, будут предъявляться строгие требования, в том числе по оценке рисков, качеству данных, документации, прозрачности, человеческому контролю и точности. Системы, представляющие ограниченный риск, например чат-боты, должны соблюдать обязательства по прозрачности, чтобы пользователи знали, что взаимодействуют не с человеком. Системы с минимальным риском, такие как игры и спам-фильтры, могут свободно использоваться.

Какая доля систем искусственного интеллекта попадет в категорию высокого риска?

Пока неясно, какая доля систем искусственного интеллекта попадет в категорию высокого риска, поскольку и область искусственного интеллекта, и законодательство все еще развиваются. Европейская комиссия в своем исследовании оценила, что только 5-15 % приложений будут подпадать под действие более строгих правил. Исследование, проведенное компанией appliedAI среди 106 корпоративных систем ИИ, показало, что 18 % из них относятся к категории высокого риска, 42 % - низкого риска и 40 % - неясного высокого или низкого риска. Системы с неясной классификацией риска в этом исследовании в основном относились к таким областям, как критическая инфраструктура, занятость, правоохранительная деятельность и безопасность продукции. В ходе соответствующего опроса 113 стартапов ЕС в области ИИ 33 % опрошенных считают, что их системы ИИ будут классифицированы как высокорисковые, в то время как Европейская комиссия оценивает их в 5-15 %.

Какие наказания предусмотрены Законом ЕС об искусственном интеллекте?

Согласно принятой Европарламентом позиции, использование запрещенных методов ИИ, описанных в статье 5, может привести к штрафам в размере до 40 млн евро или 7 % от мирового годового оборота - в зависимости от того, какая сумма выше. Несоблюдение требований к управлению данными (согласно статье 10) и требований к прозрачности и предоставлению информации (согласно статье 13) может привести к штрафам в размере до 20 млн евро или 4 % от мирового оборота, если этот показатель выше. Несоблюдение любых других требований или обязательств может привести к штрафам в размере до 10 миллионов евро или 2 % от мирового оборота - в зависимости от того, что больше. Штрафы варьируются в зависимости от нарушенного положения: запрещенная практика влечет за собой самые высокие штрафы, а другие нарушения - более низкие максимальные штрафы.

Какие меры предусмотрены в Законе ЕС об искусственном интеллекте для МСП?

Закон ЕС об искусственном интеллекте направлен на поддержку МСП и стартапов, как указано в статье 55. Конкретные меры включают предоставление приоритетного доступа МСП и стартапам, базирующимся в ЕС, к регулятивным "песочницам" при соблюдении критериев соответствия. Кроме того, для удовлетворения потребностей небольших организаций будут организованы специальные мероприятия по повышению осведомленности и развитию цифровых навыков. Кроме того, будут созданы специальные каналы связи для предоставления рекомендаций и ответов на запросы МСП и стартапов. Также будет поощряться участие МСП и других заинтересованных сторон в процессе разработки стандартов. Чтобы снизить финансовое бремя, связанное с соблюдением стандартов, для МСП и стартапов будут снижены тарифы на оценку соответствия в зависимости от таких факторов, как стадия развития, размер и рыночный спрос. Комиссия будет регулярно пересматривать затраты на сертификацию и обеспечение соответствия для МСП/стартапов (с учетом результатов прозрачных консультаций) и работать с государствами-членами над снижением этих затрат, где это возможно.

Могу ли я добровольно соблюдать Закон ЕС об искусственном интеллекте, даже если моя система не входит в сферу его действия?

Да! Комиссия, Управление по ИИ и/или государства-члены будут поощрять принятие добровольных кодексов поведения в отношении требований, предусмотренных главой 2 раздела III (например, управление рисками, управление данными и человеческий надзор), для систем ИИ, не относящихся к категории высокого риска. Эти кодексы поведения будут содержать технические решения о том, как система ИИ может соответствовать требованиям в соответствии с ее назначением. Будут учитываться и другие цели, такие как экологическая устойчивость, доступность, участие заинтересованных сторон и разнообразие команд разработчиков. При разработке кодексов поведения будут учитываться интересы малых предприятий и стартапов. См. статью 69 о кодексах поведения для добровольного применения конкретных требований.

Дайте нам знать, какие ресурсы вам нужны

Мы ищем 2-минутные отзывы о сайте AI Act, чтобы мы могли создать ресурсы, которые будут вам наиболее полезны. Мы создали многие ресурсы на нашем сайте в ответ на отзывы пользователей, иногда всего за 1-2 недели.

Этот сайт существует с целью предоставления полезной, объективной информации о событиях, связанных с Законом ЕС об искусственном интеллекте. Ежемесячно его используют более 150 тыс. пользователей. Заранее благодарим вас за ваше время и усилия – надеемся, что мы сможем отплатить вам персонализированной, высококачественной информацией, отвечающей вашим потребностям.