En su reciente publicación sobre una sólida gobernanza europea de la IA, Claudio Novelli, Philipp Hacker, Jessica Morley, Jarle Trondal y Luciano Floridi persiguen dos objetivos principales: explicar el marco de gobernanza de la Ley de IA y ofrecer recomendaciones para garantizar su ejecución uniforme y coordinada (Novelli et al., 2024).

A continuación se ofrece una visión general selectiva de la publicación, con especial atención a la Oficina de AI y al GPAI. Es importante señalar que esta visión general se abstiene de introducir nuevas perspectivas, sino que se centra únicamente en reiterar las conclusiones más relevantes de la publicación en aras de la claridad y la accesibilidad para los responsables políticos.

La publicación original está disponible en SSRN a través del enlace SSRN, o del enlace DOI.

1. Aplicar y hacer cumplir la Ley de AI: los pasos que le quedan a la Comisión

| Aspectos clave | Tareas y responsabilidades de la Comisión |

|---|---|

| a) Procedimientos | - Establecer y trabajar con la Oficina de AI y la Junta de AI para desarrollar actos de ejecución y delegados - Llevar a cabo el procedimiento de comitología con los Estados miembros para la adopción y ejecución de actos - Gestionar la adopción de actos delegados, consultando a expertos y sometiéndolos al examen del PE y el Consejo. |

| b) Directrices | - Publicar directrices sobre la aplicación de la definición de sistema de IA y las normas de clasificación de los sistemas de alto riesgo - Crear métodos de evaluación de riesgos para identificar y mitigar los riesgos - Definir normas para las "modificaciones significativas" que alteren el nivel de riesgo de un sistema de alto riesgo. |

| c) Clasificación | - Actualizar el anexo III para añadir o eliminar casos de uso de sistemas de IA de alto riesgo mediante actos delegados - Clasificar los PAMI como "de riesgo sistémico" en función de criterios como los FLOP y las capacidades de alto impacto - Ajustar los parámetros reguladores (umbrales, puntos de referencia) para la clasificación de los PAMI mediante actos delegados. |

| d) Sistemas prohibidos | - Elaborar directrices sobre las prácticas de IA prohibidas en virtud del artículo 5 (AIA) - Establecer normas y mejores prácticas para contrarrestar las técnicas manipuladoras y los peligros - Definir criterios para las excepciones a las prohibiciones, por ejemplo, para el uso policial de la identificación biométrica remota en tiempo real. |

| e) Normas armonizadas y obligaciones de alto riesgo | - Definir normas y obligaciones armonizadas para los proveedores de sistemas de alto riesgo, incluido el sistema de gestión de riesgos internos(artículo 9 de la AIA) - Normalizar los requisitos de documentación técnica y actualizar el anexo IV mediante actos delegados, según sea necesario - Aprobar códigos de buenas prácticas(artículo 56, apartado 6, de la AIA) |

| f) Información y transparencia | - Establecer obligaciones de información para los proveedores de sistemas de alto riesgo a lo largo de toda la cadena de valor de la IA - Publicar orientaciones para garantizar el cumplimiento de los requisitos de transparencia, especialmente para los GPAI. |

| g) Ejecución | - Aclarar la interacción entre la AIA y otros marcos legislativos de la UE - Regular los espacios aislados de regulación y las funciones de supervisión - Supervisar el establecimiento por parte de los Estados miembros de sanciones y medidas coercitivas que sean eficaces, proporcionadas y disuasorias. |

1.1 Directrices para la clasificación de la gripe aviar en función del riesgo

- En el marco de las evaluaciones de riesgo, la Comisión aún no ha definido normas sobre las "modificaciones importantes" que alteran el nivel de riesgo de un sistema una vez introducido en el mercado(art. 43(4) AIA). Novelli et al. esperan que el ajuste estándar de los modelos de cimentación no suponga una modificación sustancial, a menos que el proceso implique explícitamente la eliminación de capas de seguridad u otras acciones que aumenten claramente el riesgo.

- Un enfoque complementario de la evaluación de riesgos que proponen Novelli et al. consiste en adoptar planes predeterminados de gestión de cambios similares a los de la medicina; se trata de documentos en los que se describen las modificaciones previstas (por ejemplo, ajustes de rendimiento, cambios en el uso previsto) y los métodos para evaluar esos cambios.

1.2 Clasificación de la IA de propósito general (GPAI)

- La Comisión tiene una autoridad notable en virtud de la AIA para clasificar a los GPAI como "de riesgo sistémico"(art. 51 de la AIA). Novelli et al. consideran que esta distinción es crucial: sólo los GPAI con riesgo sistémico están sujetos a las obligaciones de seguridad de la IA, más trascendentales, relativas a la evaluación y el "red teaming", la evaluación y mitigación integral de riesgos, la notificación de incidentes y la ciberseguridad( art. 55 de la AIA). La Comisión puede iniciar la decisión de clasificar un IPAS como de riesgo sistémico, o hacerlo en respuesta a una alerta de la Comisión Técnica Científica.

- La Comisión puede ajustar dinámicamente los parámetros de regulación. Novelli et al. consideran que esto es esencial para un modelo de gobernanza sólido, en particular porque la tendencia en el desarrollo de la IA se orienta hacia la creación de modelos más potentes, pero "más pequeños" (que requieren menos FLOPs).

- El artículo 52 explica cómo pueden impugnar los proveedores de IPPVA las decisiones de clasificación de riesgos de la Comisión. Novelli et al. prevén que esto se convierta potencialmente en un área principal de controversia dentro de la Ley de IA. Se espera que los proveedores de GPAI cuyos modelos se entrenen con menos de 10^25 FLOPs, pero que la Comisión considere de riesgo sistémico, impugnen, posiblemente llegando hasta el Tribunal de Justicia de la Unión Europea (TJUE). Esto permite a los proveedores con bolsillos llenos retrasar la aplicación de las normas más estrictas. Al mismo tiempo, esto refuerza la importancia del umbral de 10^25 FLOP para GPAI, que se está quedando rápidamente obsoleto.

1.3 Calendario de aplicación: periodo de gracia y exenciones

- Los sistemas GPAI existentes ya en el mercado gozan de un periodo de gracia de 24 meses antes de que deban cumplir plenamente la AIA(art. 83(3) AIA). Novelli et al. señalan que, lo que es más importante, los sistemas de alto riesgo que ya estén en el mercado 24 meses después de la entrada en vigor quedan totalmente exentos de la AIA hasta que se realicen "cambios significativos" (definidos en la sección 3.2) en sus diseños (art.83(2) AIA). Sostienen que esto entra en profunda tensión con un principio de la ley de seguridad de los productos: se aplica a todos los modelos en el mercado, independientemente de cuándo entraron en el mercado. Además, el periodo de gracia para los PAMI y la exención para los sistemas de alto riesgo existentes favorecen a los titulares frente a los recién llegados, lo que es cuestionable desde el punto de vista de la competencia.

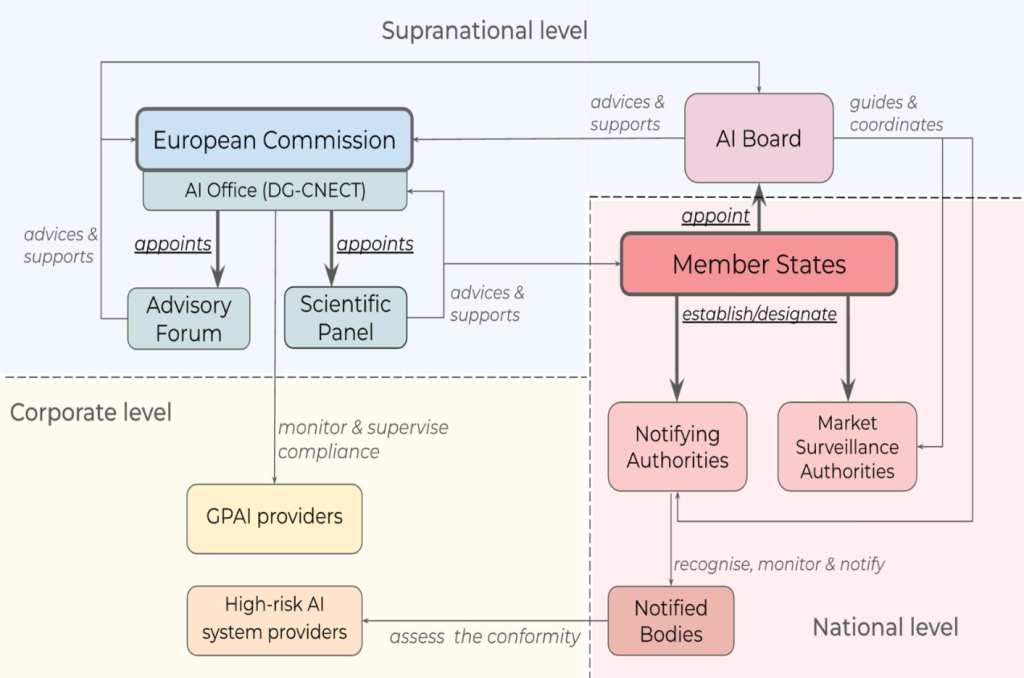

3. Autoridades supranacionales: la Oficina de AI, el Consejo de AI y los demás organismos.

| Estructura institucional | Misión y tareas |

|---|---|

| Oficina AI (Art 64 AIA y Decisión de la Comisión) Centralizada en la DG-CNECT de la Comisión | - Armonizar la aplicación y el cumplimiento de la AFP en toda la UE - Apoyar los actos de ejecución y los actos delegados - Normalización y mejores prácticas - Ayudar a crear y poner en funcionamiento espacios aislados de regulación - Evaluar y supervisar los PAMI y ayudar en las investigaciones sobre infracciones de las normas - Prestar apoyo administrativo a otros organismos (Consejo, Foro Consultivo, Comisión Científica) - Consultar a las partes interesadas y cooperar con ellas - Cooperar con otras DG y servicios pertinentes de la Comisión - Cooperación internacional |

| Junta AI (Art 65 AIA) Representantes de cada Estado miembro, con la Oficina de AI y el Supervisor Europeo de Protección de Datos participando como observadores | - Facilitar la aplicación coherente y eficaz de la AIA - Coordinar a las autoridades nacionales competentes - Armonizar las prácticas administrativas. - Emitir recomendaciones y dictámenes (a petición de la Comisión) - Apoyar la creación y el funcionamiento de espacios aislados de regulación - Recopilar información sobre las alertas relacionadas con la AIA |

| Foro consultivo (Art 67 AIA) Partes interesadas designadas por la Comisión | - Aportar conocimientos técnicos - Elaborar dictámenes y recomendaciones (a petición del Consejo y de la Comisión) - Crear subgrupos para examinar cuestiones específicas - Elaborar un informe anual de actividades |

| Comisión técnica científica (Art 68 AIA) Expertos independientes seleccionados por la Comisión | - Apoyar la aplicación de la normativa sobre IA, especialmente para los GPAI - Asesorar sobre la clasificación de los modelos de IA con riesgo sistémico - Alertar a la Oficina de IA de los riesgos sistémicos - Desarrollar herramientas y metodologías de evaluación para los GPAI - Apoyar a las autoridades de vigilancia del mercado y las actividades transfronterizas |

| Autoridades notificantes (Artt 28-29 AIA) Designadas o establecidas por los Estados miembros | - Tramitar las solicitudes de notificación de los organismos de evaluación de la conformidad (OEC) - Supervisar los OEC - Cooperar con las autoridades de otros Estados miembros - Garantizar la ausencia de conflictos de intereses con los organismos de evaluación de la conformidad - Prevención de conflictos de intereses e imparcialidad en la evaluación |

| Organismos notificados (Artt 29-38 AIA) Organismo de evaluación de la conformidad de terceros (con personalidad jurídica) notificado con arreglo a la AIA. | - Verificar la conformidad de los sistemas de IA de alto riesgo - Expedir certificaciones - Gestionar y documentar los acuerdos de subcontratación - Actividades de evaluación periódica (auditorías) - Participar en actividades de coordinación y normalización europea |

| Autoridades de vigilancia del mercado (Artt 70-72 AIA) Entidades designadas o establecidas por los Estados miembros de como ventanillas únicas | - Investigación y corrección de incumplimientos en sistemas de IA de alto riesgo (por ejemplo, medidas de riesgo) - Supervisión de pruebas en condiciones reales y gestión de informes sobre incidentes graves - Guía y asesoramiento sobre la aplicación de la normativa, en particular a PYME y empresas de nueva creación - Protección de los consumidores y apoyo a la competencia leal |

3.1 La Oficina de AI

1. Composición institucional y autonomía operativa

- Novelli et al. señalan que la estructura organizativa precisa y la autonomía operativa de la Oficina siguen siendo ambiguas. No se ha establecido ninguna disposición, ni en el AFP ni en la decisión de la Comisión, sobre la composición de la Oficina de IA, su dinámica de colaboración con los distintos Connects de la DG o el alcance de su autonomía operativa. Novelli et al. plantean la hipótesis de que esta ausencia probablemente se justifique por la expectativa de que la Oficina utilice parcialmente la infraestructura existente de la DG-CNECT. No obstante, Novelli et al. subrayan que la contratación de expertos y una financiación sustancial plantearán retos importantes, ya que la Oficina competirá con algunas de las empresas privadas mejor financiadas del planeta.

- En cuanto a su autonomía operativa, la incorporación de la Oficina a la DG-CNECT significa que el plan de gestión de la DG guiará las prioridades estratégicas de la Oficina de IA. Novelli et al. señalan que esta integración influye directamente en el alcance y la orientación de las iniciativas de la Oficina de IA.

2. Misión(es) y cometido

- La misión principal de la Oficina de la IA, según la Decisión de la Comisión, es garantizar la aplicación y el cumplimiento armonizados del AIA (art. 2, punto 1 de la Decisión). La Decisión también esboza misiones auxiliares, como potenciar un enfoque estratégico de la UE respecto a las "iniciativas" mundiales de IA, promover acciones que maximicen los beneficios sociales y económicos de la IA, apoyar los sistemas de IA que impulsen la competitividad de la UE y hacer un seguimiento de los avances del mercado de la IA.

- Novelli et al. consideran que esta redacción es muy amplia, y una interpretación que proponen es que el papel de la Oficina de la IA podría ir más allá del ámbito de la AIA para incluir marcos normativos adicionales sobre IA (como la Directiva revisada sobre responsabilidad por productos defectuosos o la Directiva sobre responsabilidad por inteligencia artificial (AILD)). En este caso, Novelli et al. observan que podría ser necesario reestructurar la Oficina para convertirla en un organismo más autónomo, como el CERT-UE, lo que podría requerir desvincularla del marco administrativo de la Comisión.

- Novelli et al. consideran que las responsabilidades asignadas a la Oficina de Inteligencia Artificial están definidas en términos generales, con la expectativa de que su aplicación precisa evolucione en función de la experiencia práctica.

- Un aspecto importante a considerar dentro del ámbito operativo de la Oficina es la naturaleza de sus decisiones. Novelli et al. señalan que la Oficina de AI no emite decisiones vinculantes por sí misma, sino que apoya y asesora a la Comisión. Plantean la preocupación de que la eficacia de los mecanismos para recurrir las decisiones de la Comisión pueda verse comprometida por la naturaleza opaca del apoyo de la Oficina de AI a la Comisión, sus interacciones dentro de la DG-CNECT y sus relaciones con organismos externos, como las autoridades nacionales. Novelli et al. consideran que esta cuestión es especialmente pertinente dado el compromiso de la Oficina de AI con expertos externos y partes interesadas. Subrayan que la documentación y la divulgación de las contribuciones de la Oficina de Inteligencia Artificial son cruciales.

3.2 La Junta Directiva de AI, el Foro Consultivo y la Comisión Científica

1. Estructuras, funciones y composición de los tres órganos

- Para Novelli et al., tener tres entidades separadas con composiciones relativamente similares plantea dudas. La Junta de AI es comprensible para garantizar la representación y mantener cierta independencia de las instituciones de la UE. Pero no está claro por qué hay un Foro Consultivo y un Grupo Científico. El Foro está pensado para diversas perspectivas de la sociedad civil y la industria, actuando esencialmente como una forma institucionalizada de lobby y equilibrando al mismo tiempo los intereses comerciales y no comerciales. En cambio, el Panel está formado por expertos independientes y (esperemos) imparciales, con tareas específicas relacionadas con el GPAI.

2. Misión(es) y tareas

- Novelli et al. señalan que el Consejo no está facultado para revisar las decisiones de las agencias nacionales de supervisión. Creen que esto puede suponer una clara desventaja, al dificultar la aplicación uniforme de la ley si algunos Estados miembros interpretan la Ley Antiterrorista de forma muy idiosincrásica. Cabe pensar, por ejemplo, en la supervisión de las limitaciones de las herramientas de vigilancia que utilizan la identificación biométrica a distancia.

- Novelli et al. consideran que la distinción entre el Foro Consultivo y la Comisión Científica es menos clara que la separación entre la Junta Directiva y la Oficina. Plantean dudas sobre la exclusividad del apoyo del Foro a la Junta y a la Comisión, dado que el Grupo apoya exclusivamente a la Oficina de AI de forma directa, y sobre si los conocimientos especializados del Grupo en materia de PAMI podrían beneficiar a estas entidades. La participación de la Oficina de AI en las reuniones de la Junta es un canal indirecto para que los conocimientos especializados del Panel influyan en debates más amplios, pero Novelli et al. consideran que este acuerdo no es del todo satisfactorio. La opinión especializada del Grupo puede tener menos impacto, ya que la Oficina de AI carece de poder de voto en las reuniones del Consejo.

4. Recomendaciones para una gobernanza sólida de la Ley de AI

Basándose en su análisis, Novelli et al. prevén las siguientes actualizaciones importantes que deberían introducirse en la estructura de gobierno de la Ley de IA.

4.1 Clarificar el diseño institucional de la Oficina de AI

- Dado el amplio abanico de tareas previstas para la Oficina de AI, se necesitan orientaciones organizativas más detalladas. Además, el mandato de la Oficina carece de especificidad en cuanto a los criterios de selección de los expertos que han de llevar a cabo las evaluaciones(considerando 164 del AIA).

- Integrar la Oficina de AI en el marco de la Comisión puede oscurecer su transparencia operativa, dada la obligación de adherirse a las políticas generales de la Comisión en materia de comunicación y confidencialidad. Por ejemplo, el derecho de acceso público a los documentos de la Comisión (Reglamento (CE) nº 1049/2001) incluye numerosas excepciones que podrían impedir la divulgación de documentos relacionados con la Oficina de AI. Novelli et al. señalan la excepción de los documentos que comprometerían "[...] los intereses comerciales de una persona física o jurídica, incluida la propiedad intelectual", una disposición definida en términos generales que carece de límites específicos y aplicables. Una interpretación más restrictiva de estas excepciones podría aplicarse a la Oficina de AI para ayudar a eludir los problemas de transparencia.

- Es necesario aclarar más la autonomía operativa de la Oficina de Inteligencia Artificial. Novelli et al. proponen que esto podría hacerse en forma de directrices sobre la autoridad para tomar decisiones, la independencia financiera y la capacidad de compromiso con partes externas.

- Un enfoque alternativo, potencialmente más eficaz, consistiría en crear la Oficina de la IA como agencia descentralizada con personalidad jurídica propia, al igual que la EFSA y la EMA. Este modelo dotaría a la Oficina de la IA de una mayor autonomía, incluida una relativa libertad respecto a las agendas políticas de la Comisión, una misión definida, poderes ejecutivos y autoridad para adoptar decisiones vinculantes. Novelli et al. observan cierto riesgo de deriva de las agencias, pero afirman que las pruebas empíricas sugieren que los principales interlocutores de las agencias de la UE son las DG "matrices" de la Comisión.

4.2 Integración del Foro y del Panel en un único órgano

- Novelli et al. sostienen que consolidar el Foro y el Panel en una entidad singular reduciría las duplicaciones y reforzaría el proceso de deliberación antes de llegar a una decisión. Esta entidad combinada fusionaría las bases de conocimiento de la sociedad civil, el sector empresarial y la comunidad académica, lo que Novelli et al. esperan que promueva debates inclusivos y reflexivos sobre las necesidades identificadas por la Comisión. Concluyen que este enfoque podría mejorar significativamente la calidad del asesoramiento a la Junta, la Oficina y las demás instituciones o agencias de la UE.

- En caso de que la fusión del Foro y el Grupo resulte inviable, una solución alternativa podría ser coordinar mejor sus operaciones, mediante una clara separación de ámbitos, funciones y tareas, pero con informes unificados. Novelli et al. sugieren elaborar un informe anual conjunto que consolide las contribuciones del Foro y del Grupo, reduciendo el solapamiento administrativo y garantizando una voz más unificada ante la Comisión, el Consejo y los Estados miembros.

- Fusionar o mejorar la coordinación entre el Foro y el Panel favorece una gobernanza sólida de la AIA al racionalizar las funciones de asesoramiento para la agilidad y la innovación, también en respuesta a los cambios tecnológicos disruptivos.

4.3 Coordinación de entidades de la UE que se solapan: el caso de un Centro de Coordinación de la IA

- A medida que las tecnologías de IA proliferan en la UE, la colaboración entre las entidades reguladoras se hace cada vez más crítica, especialmente cuando la introducción de nuevas aplicaciones de IA se cruza con intereses contrapuestos. Un ejemplo de ello es la decisión de la autoridad italiana de protección de datos de suspender ChatGPT. Novelli et al. consideran crucial incorporar mecanismos de coordinación eficaces en el marco legislativo de la UE.

- Además, consideran que el establecimiento de una plataforma centralizada, el Centro de Coordinación de Inteligencia Artificial de la Unión Europea (EU AICH), se perfila como una alternativa convincente. Novelli et al. sostienen que la creación de un centro de este tipo aumentará significativamente la uniformidad de la aplicación de la AIA, al tiempo que mejorará la eficiencia operativa y reducirá las incoherencias en el tratamiento de asuntos similares.

4.4 Control del uso indebido de la IA en la UE

- La ausencia de autoridad para que la Junta de AI revise o haga frente a las decisiones de las autoridades nacionales presenta una laguna notable a la hora de garantizar la coherencia de la normativa sobre AI. Esto es preocupante, especialmente en lo que respecta a las restricciones de la AIA sobre las herramientas de vigilancia, incluidas las tecnologías de reconocimiento facial.

- Sin la capacidad de corregir o armonizar las decisiones nacionales, existe un mayor riesgo de que la IA se utilice indebidamente en algunos Estados miembros, facilitando potencialmente el establecimiento de regímenes de vigilancia antiliberales y sofocando la disidencia legítima. Novelli et al. subrayan la necesidad de un mecanismo en el seno del Consejo de IA que garantice una aplicación uniforme de la ley e impida las aplicaciones abusivas de la IA, especialmente en ámbitos sensibles como la vigilancia biométrica.

4.5 Mecanismos de aprendizaje

- Dada su capacidad de desarrollo y ajuste más rápidos, Novelli et al. ven en la agilidad de los actos no legislativos una oportunidad para una gobernanza receptiva en la IA. Sin embargo, señalan que la agilidad del marco regulador debe corresponderse con la adaptabilidad de los organismos reguladores. Los mecanismos de aprendizaje y colaboración interinstitucionales e intrainstitucionales son esenciales para abordar los polifacéticos retos técnicos y sociales de la IA. Sugieren que podrían introducirse obligaciones específicas de revisión ex ante y ex post.

- Y lo que es más importante, Novelli et al. proponen que una unidad específica, por ejemplo dentro de la Oficina de AI, se encargue de identificar las mejores y peores prácticas en todas las entidades implicadas (desde la Oficina hasta el Foro). En colaboración con los centros de competencia de los Estados miembros, dicha unidad podría convertirse en un centro de aprendizaje y perfeccionamiento institucional e individual de la IA, dentro y fuera del marco del AIA.

Referencias

Novelli, Claudio y Hacker, Philipp y Morley, Jessica y Trondal, Jarle y Floridi, Luciano, Una gobernanza robusta para la Ley de IA: AI Office, AI Board, Scientific Panel, and National Authorities (5 de mayo de 2024). Disponible en SSRN: https://ssrn.com/abstract=4817755 o http://dx.doi.org/10.2139/ssrn.4817755