Dies ist ein Gastbeitrag, der von den Legal-Compliance-Experten Øystein Endal, Andrea Vcric, Sidsel Nag, Nick Malter und Daylan Araz (siehe Abschnitt über die Autoren am Ende) verfasst wurde. Sie stützen sich dabei auf ihre Erfahrungen aus der Leitung oder Beratung von Unternehmen, die KI integrieren. Bei Fragen oder Anregungen wenden Sie sich bitte an Nick Malter unter nick@trail-ml.com.

Haftungsausschluss: Bitte beachten Sie, dass die in diesem Artikel bereitgestellten und erörterten Informationen keine Rechtsberatung darstellen und auch nicht als solche gedacht sind. Bitte konsultieren Sie bei Bedarf professionellen Rechtsbeistand. Der Inhalt des EU-AI-Gesetzes kann anders ausgelegt werden als angegeben.

Zusammenfassung

- Diejenigen, die KI-Systeme oder -Modelle, einschließlich GPAI-Modelle, verändern, können zu Anbietern im Sinne des EU-KI-Gesetzes werden, was zu einem höheren Befolgungsaufwand führt. Eine angemessene Bewertung des KI-Systems, des Modells und des Anwendungsfalls ist entscheidend.

- Eine ordnungsgemäße Bewertung der Änderung setzt voraus, dass der Umfang des KI-Systems oder GPAI-Modells sowie die Rolle des Anbieters klar sind. Lesen Sie diesen Artikel über die "Anbieter von KI-Modellen für allgemeine Zwecke" für weitere Informationen.

- Eine Verlagerung der Compliance-Verantwortlichkeiten des Anbieters wird ausgelöst, wenn ein KI-System geändert wird und ein hohes Risiko darstellt oder wenn ein GPAI-Modell in seiner Allgemeinheit, seinen Fähigkeiten oder seinem Systemrisiko erheblich verändert wird. Dies kann der Fall sein, wenn ein GPAI-Modell feinabgestimmt wird.

- Das EU AI-Gesetz und insbesondere die Verpflichtungen für GPAI-Modellanbieter sind überschaubar. Die Aufbewahrung von technischen Unterlagen und Zusammenfassungen des GPAI-Modells ist auf den Umfang der Änderung beschränkt. In den meisten Fällen sind diese sogar für andere Zwecke als die Einhaltung der Vorschriften erforderlich.

- Die Europäische Kommission hat relativ hohe rechnergestützte Schwellenwerte dafür festgelegt, was als wesentliche Änderung von GPAI-Modellen gilt, und erwartet derzeit, dass nur wenige Modifizierer zu GPAI-Modellanbietern werden.

In diesem Beitrag geht es weiter:

- Zusammenfassung

- Einführung

- Die Probleme mit Änderungen im Rahmen des EU AI Act

- Welche Änderungen können Sie als Anbieter qualifizieren?

- GenAI in Aktion: Beispiele aus der Praxis und offene Herausforderungen

- Künftig

- Über die Autoren

Einführung

Das EU-KI-Gesetz regelt in erster Linie die Anbieter von KI-Modellen für allgemeine Zwecke (GPAI) und KI-Systemen und schafft einen umfassenden Rahmen für die Entwicklung und den Einsatz von KI in der Europäischen Union. Während das EU-KI-Gesetz den Entwickler eines völlig neuen KI-Systems oder GPAI-Modells eindeutig als Anbieter identifiziert, wird es komplexer, wenn jemand weiter unten in der Wertschöpfungskette ein bestehendes KI-System oder GPAI-Modell eines Dritten modifiziert. Dies wirft Fragen zu den Verantwortlichkeiten für die Einhaltung der Vorschriften auf, insbesondere wer die Anbieterpflichten gemäß dem EU-KI-Gesetz erfüllen sollte und kann.

Das EU-KI-Gesetz trägt den Modifizierungsszenarien Rechnung, indem es die Umstände definiert, unter denen ein Modifizierer eines KI-Systems oder eines GPAI-Modells zum Anbieter wird - und damit die regulatorischen Verpflichtungen vom ursprünglichen Anbieter teilweise oder vollständig auf den Modifizierer überträgt.

Diese Verlagerung der Compliance-Verantwortlichkeiten, insbesondere bei KI-Systemen mit hohem Risiko oder GPAI-Modellen, ist ein Szenario, das Unternehmen aufgrund der zusätzlichen Compliance-Kosten und -Lasten in der Regel zu vermeiden suchen. Eine falsche Einstufung der Rolle, der Risikokategorie oder des KI-Modells im Rahmen des EU-KI-Gesetzes stellt ein erhebliches Compliance-Risiko für Unternehmen dar, da die Nichteinhaltung der Bestimmungen zu KI-Systemen mit hohem Risiko oder GPAI-Modellen zu Geldbußen von bis zu 15 Mio. EUR oder 3 % des weltweiten Jahresumsatzes führen kann.

Mit dem Inkrafttreten der GPAI-Modellanbieterverpflichtungen ab dem 2. August 2025 werden die Diskussionen über KI-Modell- und Systemänderungen und die sich daraus ergebenden Compliance-Implikationen für Unternehmen immer dringlicher und relevanter.

In diesem Artikel erörtern wir - eine Arbeitsgruppe von KI-Pakt-Mitgliedern und frühen Anwendern des KI-Gesetzes - die Klassifizierung, die sich aus den Änderungen im Rahmen des EU-KI-Gesetzes ergibt, und diskutieren die Herausforderungen bei der Einhaltung aus Sicht der Praktiker. Wir konzentrieren uns dabei speziell auf GPAI-Modelle und -Anwendungen.

Die Probleme mit Änderungen im Rahmen des EU AI Act

Aufgrund der weit gefassten Definitionen des EU-KI-Gesetzes kann es für Unternehmen schwierig sein, herauszufinden, wann eine Änderung zu Anbieterpflichten für das verwendete Modell führt. Die entscheidende Definition einer "wesentlichen Änderung" (siehe Artikel 3(23)) bleibt im EU-KI-Gesetz vage beschrieben. Dies schafft Unsicherheit für Organisationen.

Die Herausforderung einer korrekten Klassifizierung ist besonders relevant, wenn es um Szenarien geht, in denen Unternehmen Systeme oder Anwendungen auf der Grundlage von GPAI-Modellen aufbauen, wie z. B. GPT-4.5 von OpenAI oder Sonnet 4 von Anthropic. Diese Modelle sind bewusst so konzipiert, dass sie für eine breite Palette von Anwendungsfällen anpassbar sind und von nachgelagerten Akteuren in der Wertschöpfungskette angepasst werden können. In diesen Szenarien kann die Beantwortung der Frage, wer welche Verpflichtungen zu erfüllen hat, schwierig sein.

Es gibt (laufende) Initiativen der Europäischen Kommission, die darauf abzielen, Begriffe im KI-Gesetz zu klären. In Bezug auf KI-Systeme mit hohem Risiko wird derzeit an der Entwicklung von CEN/CENELEC-Normen gearbeitet, die frühestens 2026 veröffentlicht werden sollen. Diese sollen konkrete Anhaltspunkte dafür liefern, wie die Konformitätsvermutung mit den Bestimmungen des EU-KI-Gesetzes zu risikoreichen KI-Systemen erreicht werden kann, konzentrieren sich jedoch nicht auf GPAI-Modelle. Was GPAI-Modelle betrifft, so konzentriert sich der GPAI-Praxiskodex des KI-Büros der Europäischen Kommission auf die Erfüllung der Pflichten von GPAI-Modellanbietern sowie auf GPAI-Modelle mit systemischem Risiko. Der Verhaltenskodex wurde kürzlich durch offizielle Leitlinien für GPAI-Anbieter (GPAI-Leitlinien) ergänzt. Dies sind zwar gute erste Schritte, aber es bestehen nach wie vor Unklarheiten darüber, wann ein Modifier in der Praxis zum Anbieter wird.

In den GPAI-Leitlinien wird ein Schwellenwert von einem Drittel der ursprünglichen Rechenleistung, die zum Trainieren des ursprünglichen GPAI-Modells erforderlich ist (gemessen in FLOPs), als Unterscheidung zwischen wesentlichen und unwesentlichen Änderungen eingeführt. Dieser Schwellenwert soll klären, wann die Verpflichtungen zur Einhaltung der Vorschriften auf den Modifizierer übergehen. Dieser rechnergestützte Schwellenwert ist zwar für bestimmte Änderungen wie die Feinabstimmung nützlich, kann aber für andere Arten von Änderungen, die das Verhalten und die Risiken des Modells wesentlich verändern, ohne dass umfangreiche Rechenressourcen erforderlich sind, unzureichend sein. In den Leitlinien heißt es, dass dieser Schwellenwert lediglich ein Richtkriterium ist. Im Einklang mit den GPAI-Leitlinien, Absatz 62, ist die übergreifende Regel für die Bestimmung, wann eine Änderung wesentlich ist, die Frage, ob die Änderungen potenziell zu einer wesentlichen Änderung der Allgemeinheit, der Fähigkeiten oder des systemischen Risikos des Modells führen.

In Anbetracht dieser Umstände stehen Organisationen vor der Herausforderung, die geeigneten Maßnahmen zur Einhaltung des EU-KI-Gesetzes zu ergreifen und festzustellen, ob ihre Anwendungsfälle und Änderungen sie überhaupt dazu qualifizieren, ein Anbieter (nach dem GPAI-Modell) zu werden.

Häufige Probleme bei Änderungen von KI-Modellen und -Systemen:

- Zeitplan: Die GPAI-Musterpflichten für Anbieter gelten ab dem 2. August 2025. Die Unternehmen kämpfen immer noch damit, herauszufinden, ob sie die zusätzlichen Bestimmungen für Anbieter einhalten müssen oder nicht.

- Unbestimmtheit: Die Bedingungen, unter denen Änderungen den Anbieterstatus auslösen, bleiben vage definiert, was viel Raum für Interpretationen lässt.

- Mangel an Leitlinien: Offizielle Normen von CEN/CENELEC werden nicht veröffentlicht, um die dringend benötigte Anleitung zu geben. Die GPAI-Leitlinien des AI-Büros wurden mit Verspätung veröffentlicht und lassen noch einige Fragen und Rechtsunsicherheiten offen.

- Unpraktische Vorschläge: Die in den GPAI-Leitlinien vorgeschlagenen rechnergestützten Schwellenwerte für erhebliche Änderungen sind nur von begrenztem Nutzen. Sie können schwer zu messen sein, insbesondere für nachgelagerte Akteure. Darüber hinaus erfordern andere Arten von Änderungen möglicherweise keine großen Berechnungen, können aber erhebliche Auswirkungen auf das Modell und die Risiken haben. Es bleibt die Frage, ob letzteres tatsächlich den Befolgungsaufwand im Rahmen des EU AI-Gesetzes verändert.

- Grandfathering: Es ist unklar, wie Akteure, die bestehende GPAI-Modelle nach dem 2. August 2025 wesentlich verändern, die Anbieterpflichten erfüllen müssen, wenn die vorgelagerten Modellanbieter möglicherweise erst ab August 2027 die Anbieterpflichten erfüllen müssen.

- Mangelnde Transparenz der Anbieter: Es ist schwierig, gründliche Konformitäts- und Folgenabschätzungen durchzuführen und die Kontrolle über KI-Systeme und -Modelle von Dritten zu behalten. Außerdem mangelt es oft an klar definierten vertraglichen Verpflichtungen und an Unklarheiten bezüglich der Verantwortlichkeiten aufgrund unzureichender Kommunikation der Anbieter.

Welche Änderungen können Sie als Anbieter qualifizieren?

Vor den Überlegungen, ob eine Änderung vorliegt, die jemanden als Anbieter qualifizieren kann, ist es ratsam zu prüfen, ob das betreffende System oder Modell tatsächlich in den Anwendungsbereich der Definitionen des EU-KI-Gesetzes für ein KI-System oder GPAI-Modell fällt. Dies mag trivial erscheinen, aber bei der Einstufung der Betreiberrolle hat es sich mitunter als schwierig erwiesen.

Es gibt verschiedene Möglichkeiten, ein Anbieter im Sinne des EU-KI-Gesetzes zu werden, sowohl auf der Ebene des KI-Systems als auch des KI-Modells. Insbesondere werden im EU-KI-Gesetz mehrere Szenarien beschrieben, in denen ein Unternehmen, das ein KI-System modifiziert oder einsetzt, potenziell die Rolle und die Verantwortlichkeiten eines Anbieters übernehmen kann:

- Integration eines bestehenden KI-Modells in ein neues oder bestehendes KI-System (siehe Artikel 3 Nummer 68)

- Rebranding eines risikoreichen AI-Systems als eigenes Produkt (siehe Artikel 25)

- Umwidmung eines KI-Systems oder -Modells, so dass es zu einem Hochrisikosystem wird (siehe Artikel 25)

- (Wesentliche) Änderungen an einem bestehenden AI-System mit hohem Risiko oder einem GPAI-Modell (siehe Artikel 25 und Erwägungsgrund 109)

Der erste Fall bezieht sich auf die im EU-KI-Gesetz enthaltene Definition eines "nachgeschalteten Anbieters" (siehe Artikel 3 Absatz 68), die wahrscheinlich die derzeitigen Umstände vieler Organisationen am besten beschreibt. So kann beispielsweise das Einbringen eines eigenen Modells ("BYOM") in ein KI-System als Integration gelten. Die Tatsache, dass es sich um einen nachgelagerten Anbieter handelt, führt jedoch nicht zwangsläufig zu einer Verschiebung der Compliance-Verantwortlichkeiten für Anbieter von GPAI-Modellen, da dies eher die Rolle eines KI-Systemanbieters beschreibt. In dieser Situation müsste eine Organisation prüfen, ob die hochriskanten KI-Systeme oder Transparenzverpflichtungen gelten und ob der vorgelagerte Anbieter des GPAI-Modells den Vertrieb und die Nutzung des Modells innerhalb der EU eindeutig ausgeschlossen hat.

Während der zweite und dritte Fall - Rebranding und Repurposing - im Allgemeinen recht einfache Schwellenwerte für eine Verlagerung der Verantwortung für die Einhaltung der Vorschriften darstellen, sind die Fälle, in denen es um wesentliche Änderungen geht, mehrdeutig und stellen die Organisationen, wie oben beschrieben, vor erhebliche Auslegungsprobleme.

Erhebliche Änderungen an KI-Systemen

Gemäß dem AI-Gesetz bezieht sich eine wesentliche Änderung auf eine Änderung eines AI-Systems, die in der Konformitätsbewertung des ursprünglichen Anbieters nicht vorgesehen war und die sich auf die Einhaltung der Anforderungen an AI-Systeme mit hohem Risiko auswirkt oder die den beabsichtigten Zweck des AI-Systems beeinträchtigt (siehe Artikel 3 Absatz 23 und Erwägungsgrund 128). Beachten Sie, dass eine offizielle Konformitätsbewertung für ein AI-System mit hohem Risiko nur durchgeführt werden kann, wenn es benannte Stellen gibt, die ein externes Audit durchführen, oder wenn die harmonisierten Normen (von CEN/CENELEC) angewendet werden können. Zum Zeitpunkt der Abfassung dieses Berichts ist dies daher noch keine hilfreiche Anleitung.

Das AI-Gesetz befasst sich außerdem ausdrücklich mit Änderungen in Artikel 25, in dem es heißt, dass wesentliche Änderungen an einem AI-System mit hohem Risiko die Rolle des Anbieters auf den Modifizierer verlagern - allerdings nur, wenn das System weiterhin ein hohes Risiko aufweist. Damit wird das Konzept der wesentlichen Änderungen mit den Auswirkungen der Änderung auf das Risikoniveau verknüpft.

Erhebliche Änderungen der GPAI-Modelle

Wenn es um Änderungen von GPAI-Modellen geht, ist das EU AI-Gesetz jedoch weniger eindeutig. Erwägungsgrund 109 und die FAQ der Europäischen Kommission stellen klar, dass die Verpflichtungen des Anbieters für GPAI-Modelle auf den Umfang der Änderung beschränkt sind, aber das EU AI-Gesetz verknüpft Änderungen an GPAI-Modellen nicht direkt mit bestimmten Risikostufen (nur mit systemischen oder nicht-systemischen Risiken). Darüber hinaus spricht das EU AI-Gesetz nicht ausdrücklich von wesentlichen Änderungen im Zusammenhang mit GPAI-Modellen - aber es hebt ausdrücklich die Feinabstimmung von GPAI-Modellen als Änderung hervor, was darauf hindeutet, dass die Änderung auch eine ziemlich wesentliche Auswirkung auf das Modell haben muss. Das Amt für künstliche Intelligenz bestätigt letzteres in den GPAI-Leitlinien, da es feststellt, dass seiner Ansicht nach Änderungen in der Regel das Trainieren eines Modells mit zusätzlichen Daten beinhalten. In den Leitlinien wird auch ausführlich auf die Feinabstimmung und das erneute Training eines GPAI-Modells eingegangen.

Um diese Unterscheidung weiter zu unterstützen, führen die GPAI-Leitlinien einen rechenbasierten Schwellenwert ein: Wenn eine Modifikation mindestens ein Drittel der ursprünglich für das Training des Modells benötigten Rechenressourcen nutzt, wird davon ausgegangen, dass der Modifikator ein GPAI-Modellanbieter geworden ist. Dieser Schwellenwert schafft zwar etwas mehr Klarheit, aber seine Grenzen wurden während der öffentlichen Konsultation zu den Leitlinien hervorgehoben und vom AI-Büro eingeräumt. Der Schwellenwert erfasst möglicherweise keine Änderungen mit geringem Rechenaufwand, die sich dennoch erheblich auf das Risikoprofil eines Modells auswirken, und es kann für Modifizierer schwierig sein, den erforderlichen Rechenaufwand zuverlässig zu schätzen - insbesondere ohne Zugang zu Informationen von vorgelagerten Anbietern. Die Europäische Kommission hat sich für relativ hohe Schwellenwerte entschieden und erwartet derzeit, dass nur wenige Modifizierer GPAI-Modellanbieter werden.

Auch hier ist der Schwellenwert ein indikatives Kriterium, und andere Modelländerungen könnten ebenfalls als wesentliche Änderungen eingestuft werden. Ob die risikoorientierte Logik von Artikel 25 (der Artikel, der Änderungen an AI-Systemen mit hohem Risiko regelt) auch auf die Änderungen von GPAI-Modellen anwendbar ist, wie von einigen vorgeschlagen, bleibt eine offene Frage.

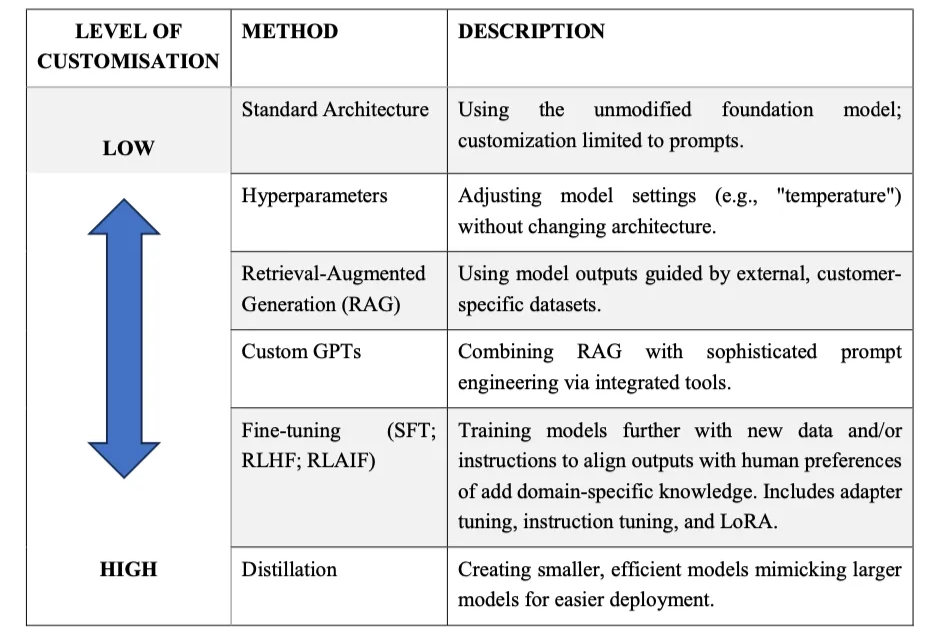

Eine Änderung eines KI-Modells kann viele Formen annehmen. Wie von Philipp Hacker und Matthias Holweg (2025) dargelegt, lassen sich die wichtigsten Arten von Änderungen an einem KI-Modell in die folgenden Kategorien einteilen:

- Keine Änderung: Verwendung eines vortrainierten KI-Modells ohne jegliche Änderungen.

- Ändern von Hyperparametern: Anpassen von Parametern wie der Temperatur.

- Retrieval-Augmented Generation (RAG): Entwicklung von Anwendungen, die die Ergebnisse eines Modells durch Bezugnahme auf eine externe Wissensbasis oder eigene Daten verbessern.

- Benutzerdefinierte GPTs: Erstellen von Varianten von Basismodellen mit bestimmten Anweisungen, Werkzeugen und Persönlichkeiten.

- Feinabstimmung: Training des Basismodells auf eigenen oder domänenspezifischen Datensätzen, um seine Leistung anzupassen.

Modell- oder Wissensdestillation: Training eines kleineren "Schüler"-Modells auf der Grundlage der Ergebnisse eines größeren "Lehrer"-Modells, oft um den Rechenaufwand zu verringern.

Wie Hacker und Holweg (2025) argumentieren, liegen wesentliche Änderungen, d. h. wesentlich veränderte Risikoprofile oder Modellverhalten, in Fällen von Feinabstimmung, Modelldestillation, Jailbreaking durch Parametermanipulation oder Änderung der Kernarchitektur eines Modells vor. Andere Änderungen, insbesondere wenn sie das Risikoprofil, die Architektur, die Allgemeinheit oder den beabsichtigten Zweck eines KI-Modells nicht verändern, sind wahrscheinlich unwesentlich, d. h. sie lösen keine Änderung der GPAI-Modellanbieterpflichten aus.

Was bedeutet das für die Praxis?

Der allgemeinen Logik des EU-KI-Gesetzes folgend ist es sinnvoll, die Bewertung, ob sich die Pflichten zur Einhaltung der Vorschriften sowohl in Bezug auf KI-Systeme als auch auf GPAI-Modelle ändern, in einer Bewertung zu verankern, ob die Änderung wesentlich oder unwesentlich ist - was wiederum eine Betrachtung der Auswirkungen der Änderung auf die Risiken erfordert.

Bei KI-Systemen ist die Aufgabe relativ klar: Unternehmen, die KI-Systeme ändern, sollten überprüfen, ob sich die Änderungen auf die Risikoeinstufung des Systems auswirken, z. B. ob es risikoreich wird oder risikoreich bleibt.

Bei GPAI-Modellen ist die Angelegenheit etwas komplexer. Solange keine weiteren Leitlinien und Standards verfügbar sind, können Unternehmen, die GPAI-Modelle ändern, zwei Ansätze in Betracht ziehen:

- Ein konservativerer Ansatz, bei dem jede Anpassung als potenzieller Auslöser für einen Wechsel der GPAI-Modellanbieterverpflichtungen betrachtet wird. Dies beinhaltet im Wesentlichen die Führung von Dokumentationen und Zusammenfassungen der durchgeführten Änderungen, auch wenn diese nicht zwingend erforderlich sind.

- Ein pragmatischerer Ansatz, bei dem davon ausgegangen wird, dass die Verpflichtungen des GPAI-Modellanbieters nur dann gelten, wenn die Änderung das Verhalten, die Allgemeinheit oder das Risikoprofil des Modells eindeutig verändert oder wenn die Berechnungsschwellenwerte erreicht werden. Dieser Ansatz begrenzt den Verwaltungsaufwand, kann aber im Falle einer Anfechtung stärkere Begründungen erfordern.

In jedem Fall sollten Unternehmen Risiko- und Folgenabschätzungen durchführen, wenn sie Änderungen an GPAI-Modellen oder (risikoreichen) KI-Systemen vornehmen.

GenAI in Aktion: Beispiele aus der Praxis und offene Herausforderungen

Um einen Eindruck von den aktuellen Herausforderungen für Praktiker zu vermitteln, wenn es um die richtige Kategorisierung geht, haben wir einige (teilweise anonymisierte) reale Fallbeispiele zusammengestellt. Wir beleuchten auch weitere Compliance-Herausforderungen im Rahmen des KI-Gesetzes, die mit GenAI-Fällen zusammenhängen und noch zu lösen sind, sowie weitere Best Practices.

Fall 1: IT-Dienstleister für Unternehmen

Ein IT-Dienstleister nutzt das GPT-4-Modell von OpenAI, um eine Plattform bereitzustellen und zu verkaufen, die verschiedene Chatbots in einer zentralisierten Lösung orchestriert. Endnutzer können dann sowohl mit den Bots chatten, um auf allgemeines Wissen zuzugreifen, als auch auf unternehmensinternes Wissen, und das in einer sicheren Umgebung. Hierbei handelt es sich um einen sehr häufigen "Custom GPT"-Fall, bei dem der Dienstanbieter seine Änderungen auf die Änderung von Prompts und das Hinzufügen von RAG-Techniken beschränkt und das System unter einem neuen Namen vertreibt.

Die folgenden Überlegungen waren für den IT-Dienstleister bei der Bewertung der Einhaltung der Vorschriften besonders wichtig:

- Erstens war unklar, ob die Entwicklung von maßgeschneiderten Bots auf der Grundlage des GPT-4-Modells und die Erbringung von Dienstleistungen unter ihrem eigenen Markennamen sie als GPAI-Modellanbieter qualifiziert.

- Zweitens herrschte Verwirrung darüber, ob die GPAI-Frist vom 2. August 2025 für den Verkauf von GPT-basierten Lösungen gilt, ohne dass das Kernmodell wesentlich geändert wird.

- Drittens haben sie Schwierigkeiten damit, sicherzustellen, dass OpenAI die erforderliche Dokumentation liefert.

Der IT-Dienstleister gilt zwar als nachgeschalteter Anbieter, doch aufgrund der Integration des OpenAI-Modells qualifiziert er sich weder als Anbieter eines risikoreichen KI-Systems (das in der Nutzungsrichtlinie ausgeschlossen und durch technische Mittel eingeschränkt ist) noch als GPAI-Modellanbieter, da der Umfang der Änderungen sehr begrenzt ist und das Risiko des Modells nicht wesentlich verändert wird. In diesem Fall und zumindest für die Zwecke der Einhaltung der Vorschriften müssen sie sich nicht auf die Dokumentation von OpenAI stützen und haben keine zusätzlichen Verpflichtungen im Rahmen der GPAI-Modellbestimmungen. Der IT-Dienstleister beriet sich mit der Compliance-Firma eines der Autoren, Trail, und beschloss, einen konservativen Ansatz zu verfolgen, d. h. eine ausreichende technische Dokumentation über die Architektur und Funktionalität des GPAI-Systems vorzuhalten, die ohnehin für Entwicklungszwecke zur Verfügung stehen sollte.

Fall 2: Agentenbasierte KI-Plattform für Scale-up

Das Schweizer Scale-up-Unternehmen Unique AI bietet eine Plattform für den Aufbau von agentenbasierten KI-Lösungen, die Banken, Versicherungen und Private-Equity-Firmen bei der Verbesserung ihrer Finanzgeschäfte helfen. Dazu gehören Workflows wie Investment Research, Due Diligence und KYC-Prozesse. Die größte Herausforderung dabei war die Gewährleistung der Compliance und der angemessenen Sicherheit von KI-Agenten, die in der Lage sind, eigenständig Aktionen durchzuführen. Allerdings war die Rolle im Rahmen des EU-KI-Gesetzes anfangs unklar.

Unique AI hat sowohl intern als auch mit Unterstützung der Anwaltskanzlei WalderWyss eingehende Recherchen zum EU-KI-Gesetz durchgeführt und ein Rechtsgutachten über die Positionierung von Unique AI im Hinblick auf das EU-KI-Gesetz eingeholt. Je nach Kundenkonfiguration und Einsatzmodell kann Unique AI im Rahmen des EU-KI-Gesetzes verschiedene Rollen einnehmen.

Die meisten Kunden haben sich für ein Single-Tenant-Bereitstellungsmodell entschieden, bei dem Unique AI die Software hostet und betreibt. Basierend auf der rechtlichen Auslegung des EU-KI-Gesetzes positioniert sich Unique AI bei der Bereitstellung der KI-Systeme und -Modelle eher als Händler denn als Anbieter. Das liegt daran, dass Unique AI bestehende kommerzielle KI-Produkte wie Microsoft Azure und OpenAI-Modelle nutzt und sie durch Prompt-Chaining, RAG und Prompt-to-SQL-Techniken mit kontextspezifischen Funktionalitäten anreichert, ohne das ursprüngliche Large Language Model (LLM) zu verändern. Unique AI verwendet keine Kundendaten für die Modellschulung und schließt die Verwendung für risikoreiche Zwecke aus, was diese Einstufung weiter unterstützt. Daher betrachtet sich das Unternehmen nicht als Modifizierer des GPAI-Modells und die Verpflichtungen des GPAI-Modellanbieters verbleiben auf der Seite der Upstream-Anbieter.

Sie haben ein KI-Governance-Framework eingeführt, das als Grundlage für ihre agentenbasierte KI-Entwicklung dient und Vertrauen, Sicherheit, Verantwortlichkeit, Zuverlässigkeit und Transparenz in die Kernarchitektur jedes intelligenten Agenten und Workflows einbettet, während regelmäßiges internes Benchmarking ein Abdriften des Modells verhindert und eine konsistente Qualität für alle Anwendungsfälle gewährleistet.

Um proaktiv auf die Einhaltung des KI-Gesetzes hinzuarbeiten, führte Unique AI im Juni 2024 eine interne Konformitätsbewertung nach der Methodik von David Rosenthal durch, die vom Chief Information Security Officer und Chief Data Officer des Unternehmens geleitet wurde.

Da sich das regulatorische Umfeld ständig weiterentwickelt, verfolgt das Unternehmen einen vorausschauenden Ansatz, indem es sein öffentliches KI-Governance-Rahmenwerk kontinuierlich aktualisiert, sich aktiv an regulatorischen Konsultationen beteiligt und durch Initiativen wie die jährlich stattfindenden KI-Governance-Roundtables offen und transparent mit Branchenkollegen zusammenarbeitet.

Künftig

Während die Umsetzung des EU-KI-Gesetzes weiter voranschreitet, bleiben offene Fragen und Compliance-Herausforderungen bestehen, insbesondere für Unternehmen, die KI-Modelle und -Systeme integrieren und verändern.

In jedem Fall sind die Gesamtverpflichtungen für GPAI-Modellanbieter überschaubar, da sie sich im Wesentlichen darauf beschränken, die technische Dokumentation und Zusammenfassungen im Rahmen der Änderungen zu halten. Für GPAI-Modellanbieter mit systemischen Risiken ergeben sich natürlich komplexere Compliance-Anforderungen. Das AI Office geht davon aus, dass zum jetzigen Zeitpunkt nur wenige nachgelagerte Modifikationen die entsprechenden Berechnungsschwellen erreichen würden, die eine Verlagerung der Compliance-Verantwortlichkeiten auslösen würden. Entsprechende Leitlinien sind in Arbeit, und es gibt genügend Hinweise und Stellvertreter, die es sowohl den Integratoren als auch den Modifikatoren ermöglichen, in der Zwischenzeit auf die Einhaltung des EU-KI-Gesetzes hinzuarbeiten.

Das AI-Büro hat in den GPAI-Leitlinien auch darauf hingewiesen, dass Anbieter von GPAI-Modellen, einschließlich derjenigen, die Änderungen vornehmen, die Schwierigkeiten bei der Einhaltung der Frist im August 2025 erwarten, sich proaktiv mit dem AI-Büro über seinen kürzlich eingerichteten AI Act Service Desk in Verbindung setzen sollten. Die von einzelnen EU-Mitgliedstaaten eingerichteten AI Act Service Desks, wie z. B. die von Deutschland und Österreich, können eine weitere Möglichkeit sein, sich in komplexen Fällen proaktiv an die Behörden zu wenden.

Darüber hinaus haben sich viele große Anbieter von GPAI-Modellen dem GPAI-Verhaltenskodex verpflichtet, darunter OpenAI, Anthropic, Google und Mistral, was darauf hindeutet, dass auch die Absicht besteht, nachgelagerte Betreiber mit einer angemessenen Dokumentation über KI-Modelle zu unterstützen. Dies kann dazu beitragen, den oben erwähnten Mangel an Anbietertransparenz in den kommenden Monaten abzumildern.

Allgemeine Empfehlungen für Organisationen

Wenn Sie sich über Änderungen von GPAI-Modellen und -Systemen im Rahmen des EU-KI-Gesetzes Gedanken machen, sollten Sie die offiziellen GPAI-Leitlinien des AI-Büros durchlesen und die Anwendungsfälle anhand der Interpretationen des AI-Büros bewerten. Die Leitlinien enthalten weitere Beispiele dafür, wann eine Organisation als GPAI-Modellanbieter anzusehen ist.

Organisationen, die jetzt damit begonnen haben, sich eingehender mit der Einhaltung des EU-KI-Gesetzes zu befassen, sollten ihren Schwung nutzen und proaktiv mit KI-Governance-Initiativen beginnen, wobei zu beachten ist, dass KI-Governance viel weiter gefasst ist als die Einhaltung von Vorschriften.Freiwillige Programme wie der KI-Pakt bieten Möglichkeiten zum kollegialen Austausch rund um das EU-KI-Gesetz und können dazu beitragen, interne Zustimmung zu gewinnen und ein Bewusstsein für KI-Governance zu schaffen. Die Autoren dieses Artikels haben beispielsweise Anfang des Jahres proaktiv eine kleine, informelle Gemeinschaft von KI-Pakt-Mitgliedern ("AIPEX") gegründet, um aktuelle Herausforderungen und Lösungen für diese in direkten Treffen zu diskutieren, und Mitglieder des KI-Büros nahmen sich die Zeit, an einem ihrer Treffen teilzunehmen.

Empfohlene Maßnahmen und Ressourcen für die Vorbereitung des EU-AI-Gesetzes

- Katalogisieren und klassifizieren Sie KI-Nutzungsfälle und -Systeme, da dies die Grundlage für eine angemessene Bewertung der Rolle und des Risikos gemäß dem EU-KI-Gesetz ist. Sie können kostenlose Compliance-Checker nutzen, z. B. vom KI-Büro, auf der Website des KI-Gesetzes oder vom KI-Governance-Plattformanbieter Trail. In Grenzfällen führen Sie eine gründliche Analyse intern und extern durch, z. B. mit einer Anwaltskanzlei.

- Durchführung von Risiko- und Folgenabschätzungen bei der Integration oder Anpassung von GPAI-Modellen und KI-Systemen.

- Dokumentieren Sie alle Änderungen an KI-Systemen oder -Modellen. Dies ist eine einfache Maßnahme, die vor allem in Zeiten der Rechtsunsicherheit nützlich ist. Selbst wenn keine rechtlichen Verpflichtungen bestehen, ist dies für interne Stakeholder oder Kunden oft nützlich und notwendig.

- Bleiben Sie über die Entwicklungen rund um das EU-KI-Gesetz auf dem Laufenden , um proaktiv auf die Einhaltung der neuen Leitlinien hinzuarbeiten. Detailliertere Analysen und Stellungnahmen können auch dabei helfen, Ihre Governance-Ansätze zu verfeinern, wie z. B. der von Hacker und Holweg (2025) vorgeschlagene Ansatz des "Compute and Consequence Screening" zur granularen Differenzierung von KI-Modelländerungen.

Über die Autoren

Von der informellen AI Pact Exchange Group ("AIPEX"):

- Øystein EndalKI-Risiko- und Compliance-Manager in der Finanzdienstleistungs- und Versicherungsbranche.

- Andrea VrcicRechtsberaterin für KI-Regulierung im Finanzdienstleistungs- und Versicherungssektor.

- Sidsel NagManagerin für KI-Ethik, -Regulierung und -Governance in der Beratungsbranche und Mitglied des dänischen Normungsausschusses.

- Nick MalterManager für KI-Politik und Governance bei der trail GmbH, einem Unternehmen für KI-Governance-Software. Initiator der AIPEX-Gruppe.

Von Unique AI:

Daylan Araz ist Data Compliance Officer bei Unique AI in Zürich. Er war massgeblich an der Entwicklung des umfassenden AI Governance Frameworks von Unique beteiligt. Er war federführend bei der Erlangung der ISO 42001-Zertifizierung und trug zu den Zertifizierungen nach ISO 27001, ISO 9001 und SOC 2 bei. Kontaktieren Sie uns für weitere Informationen: aigovernance@unique.ai.